Cuando transacción a través de enlaces en nuestros artículos, Future y sus socios de sindicación pueden triunfar una comisión.

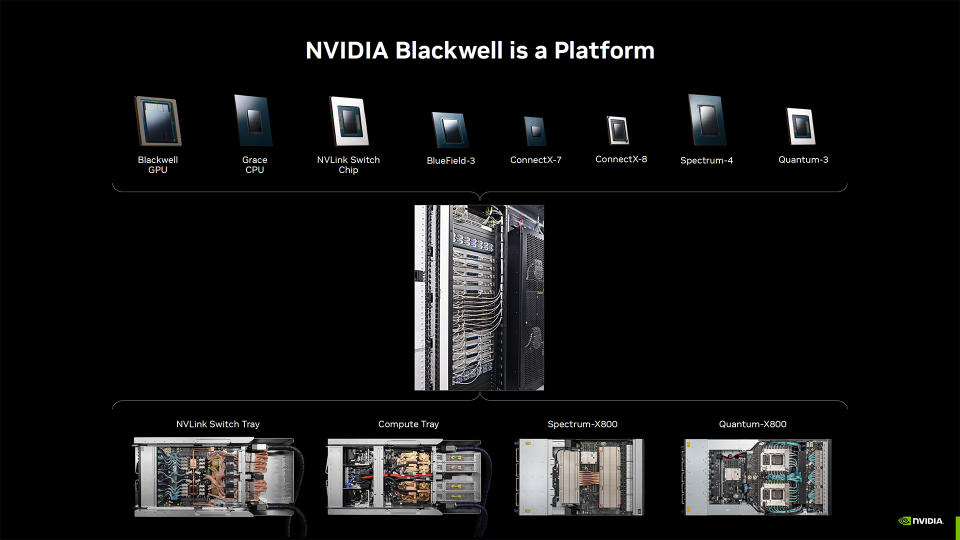

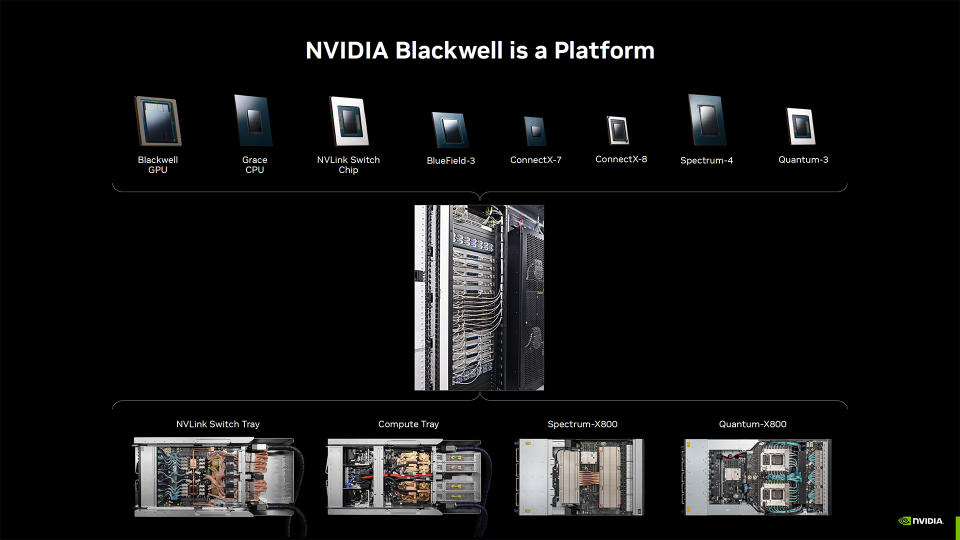

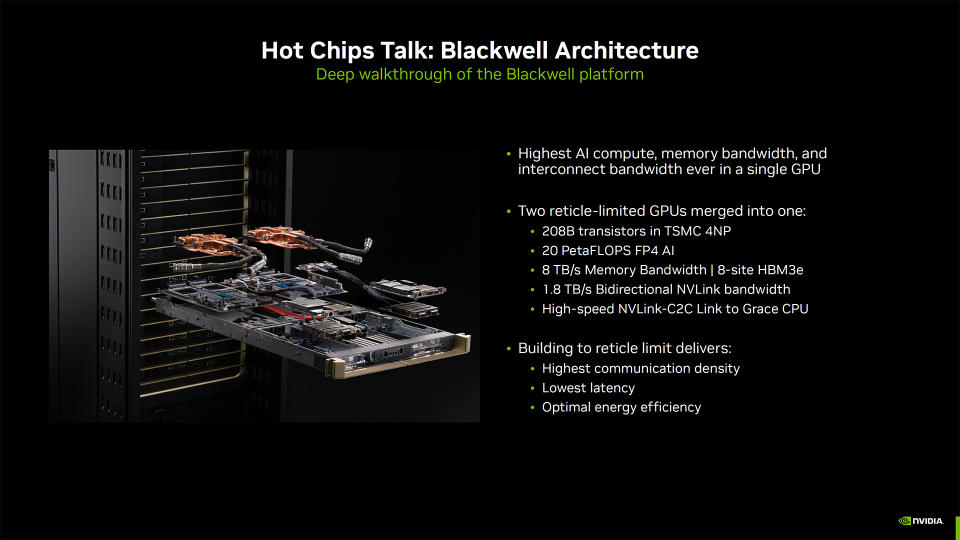

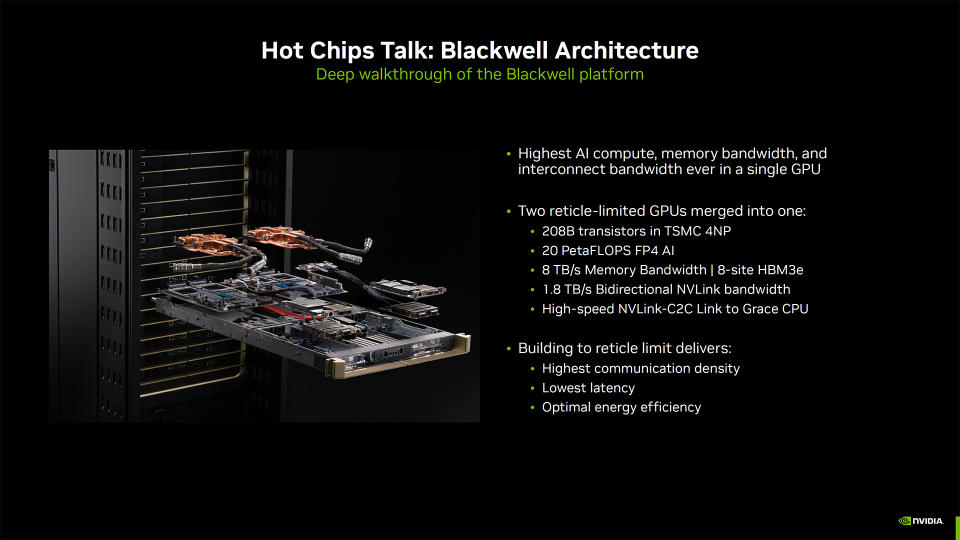

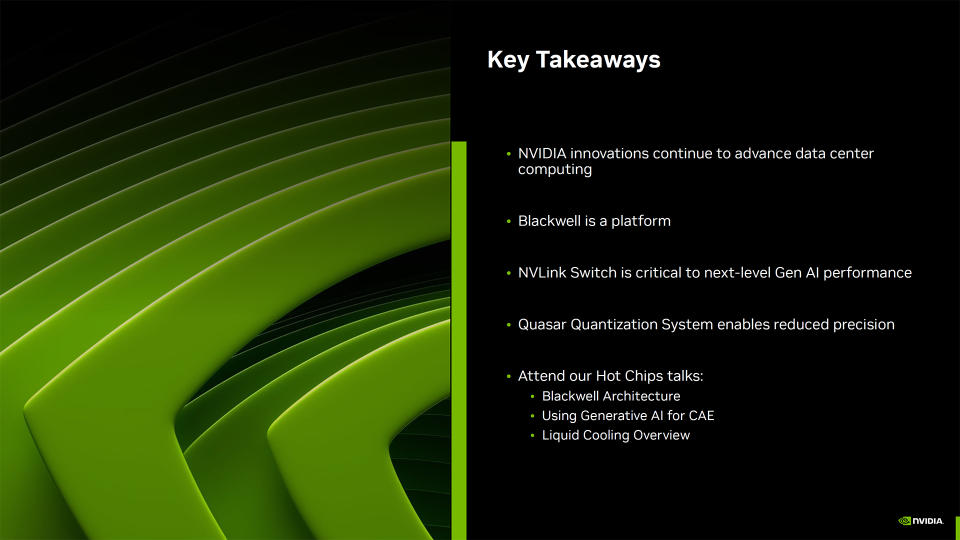

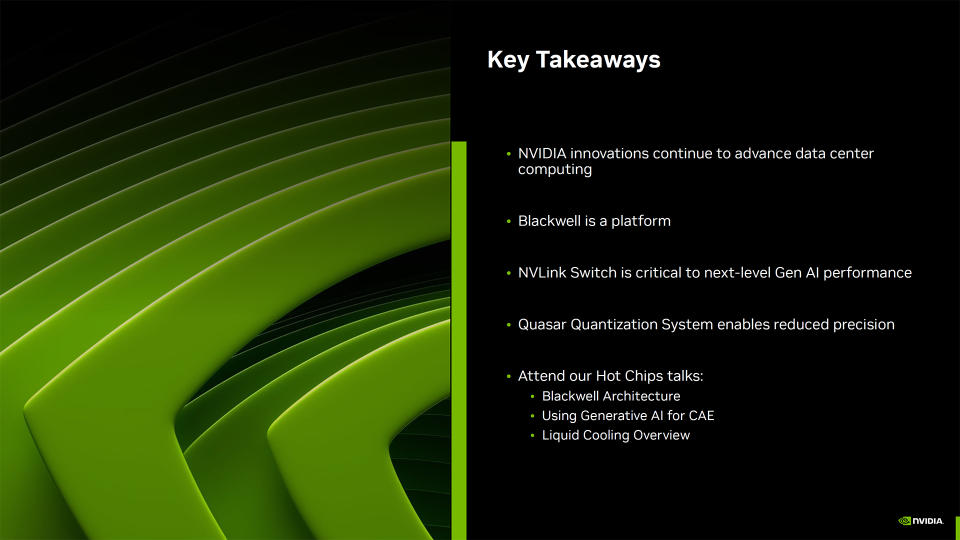

Ayer del inicio de la feria Hot Chips 2024, Nvidia mostró más utensilios de su plataforma Blackwell, incluidos los servidores que se están instalando y configurando. Es una forma poco sutil de proponer que Blackwell sigue en camino, sin importar los retrasos. Además habló sobre sus soluciones Hopper H200 existentes, mostró optimizaciones FP4 LLM utilizando su nuevo sistema de cuantificación Radiofuente, analizó la refrigeración líquida con agua caliente para centros de datos y habló sobre el uso de la IA para ayudar a construir chips aún mejores para la IA. Reiteró que Blackwell es más que una GPU, es una plataforma y un ecosistema completos.

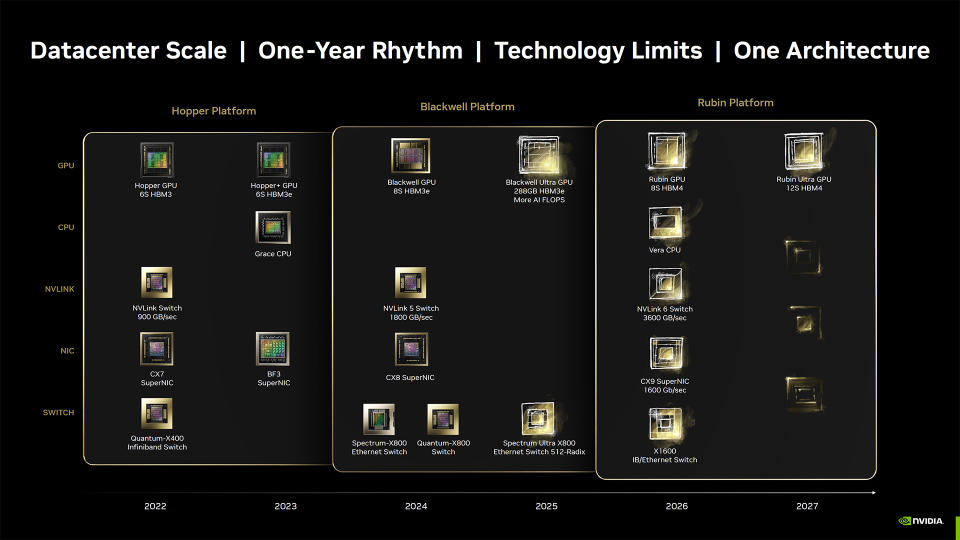

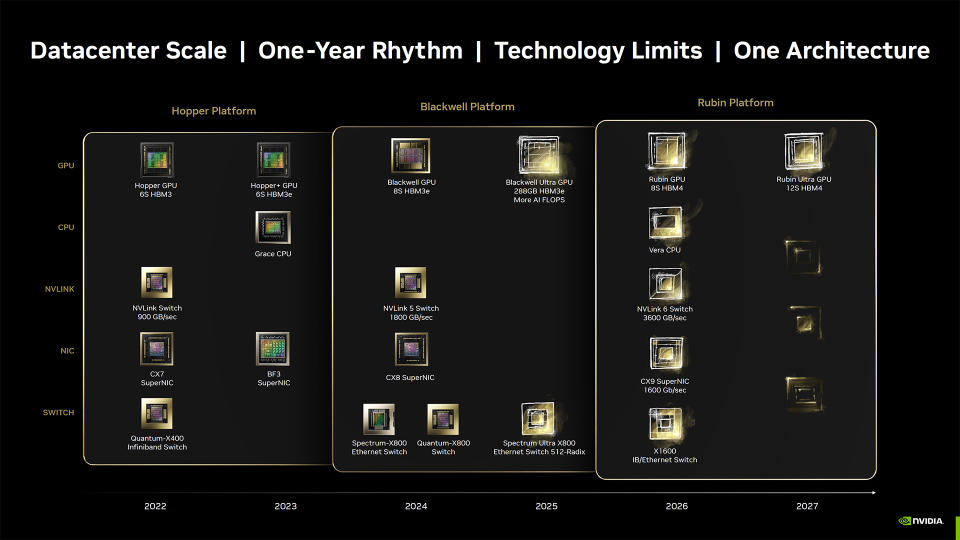

Gran parte de lo que presentará Nvidia en Hot Chips 2024 ya se conoce, como la hoja de ruta de IA y centros de datos que muestra que Blackwell Extremista llegará el próximo año, con CPU Orilla y GPU Rubin en 2026, seguidas por Orilla Extremista en 2027. Nvidia confirmó por primera vez esos detalles en Computex en junio. Pero la IA sigue siendo un tema importante y Nvidia está más que oportuno de seguir haciendo ruido en torno a ella.

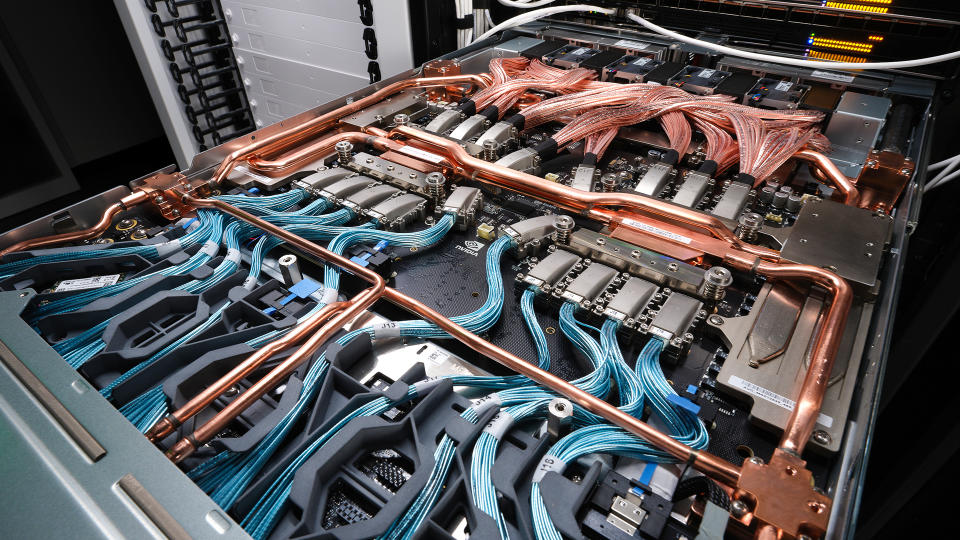

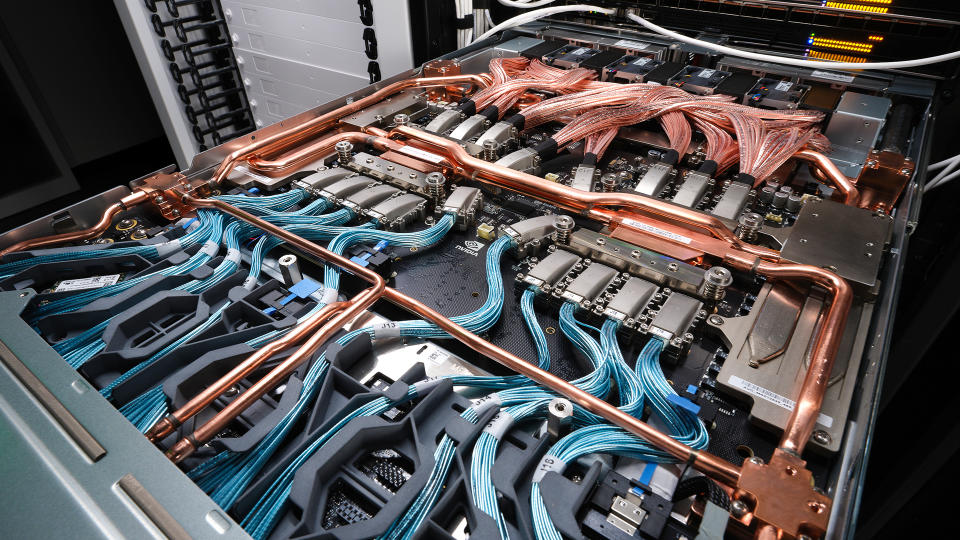

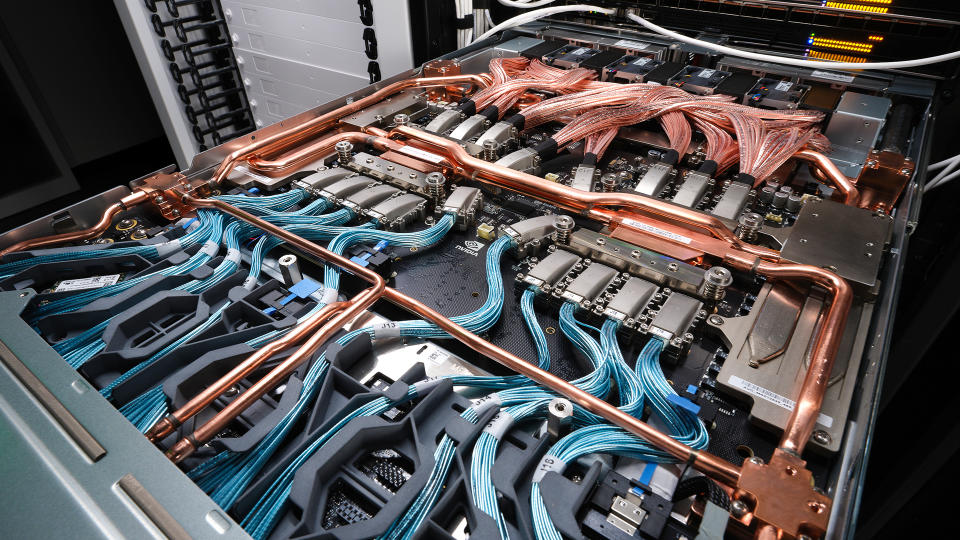

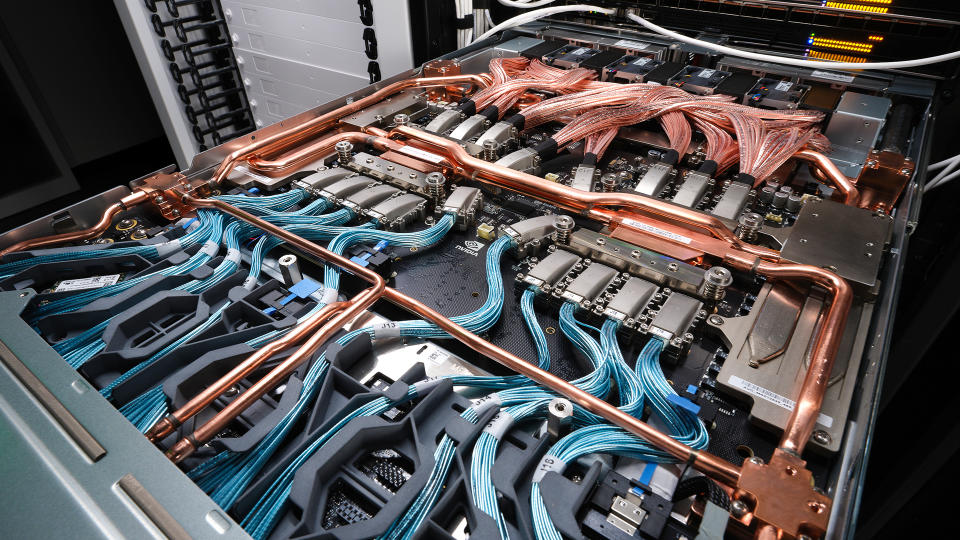

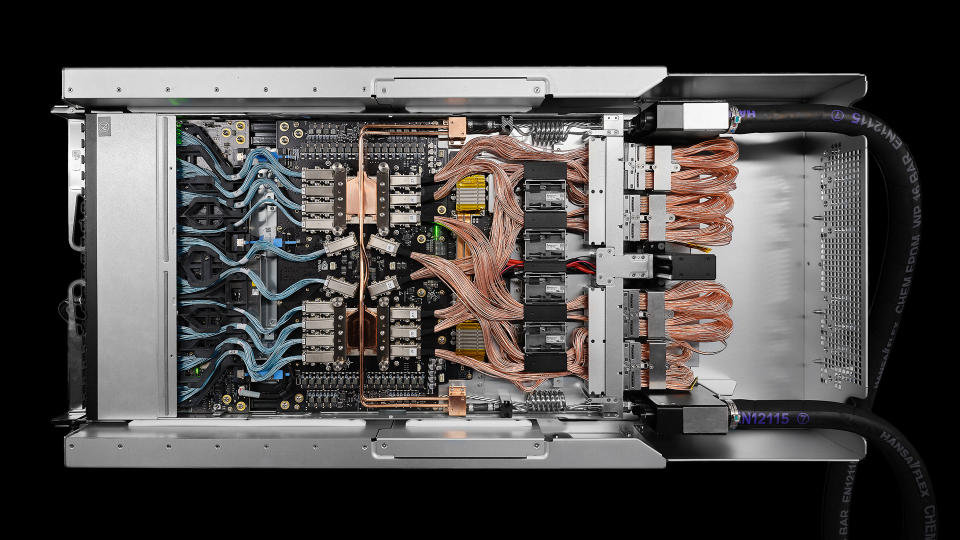

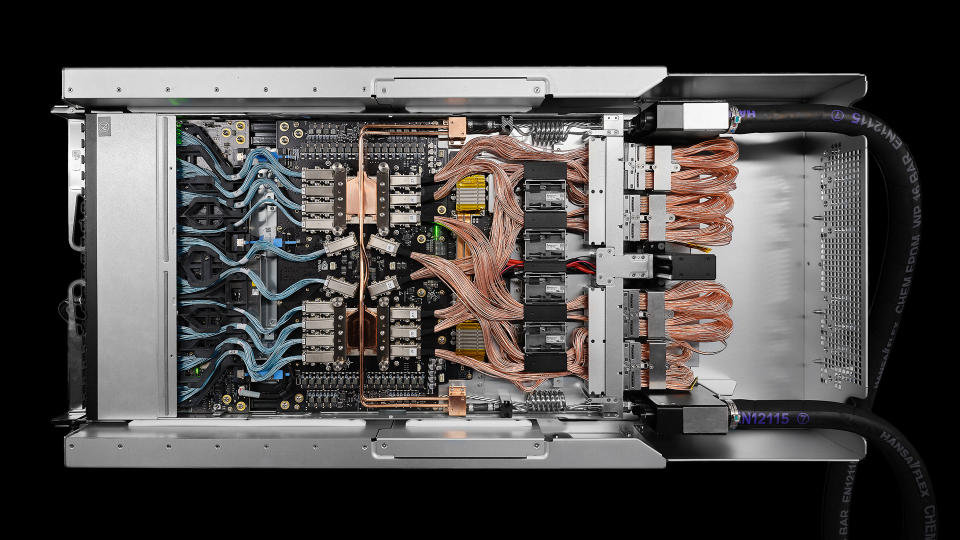

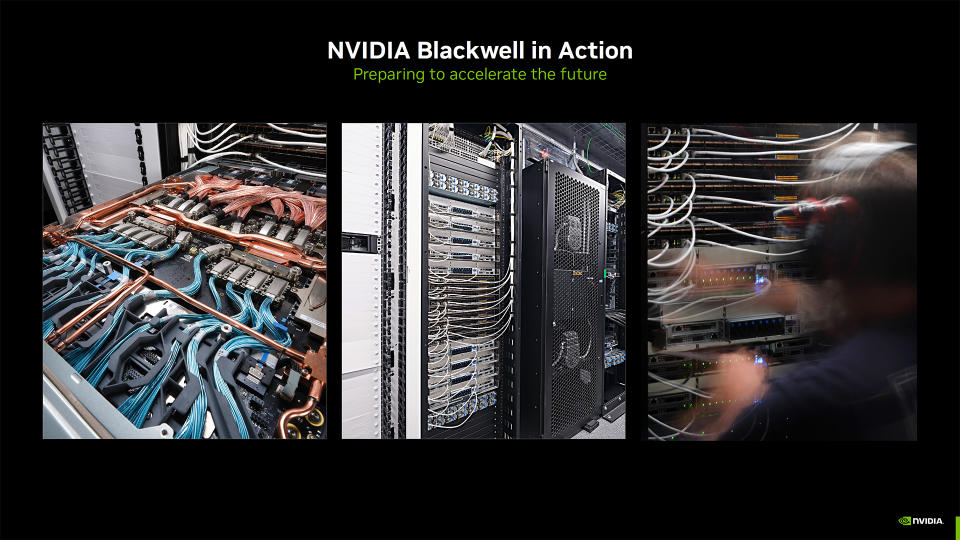

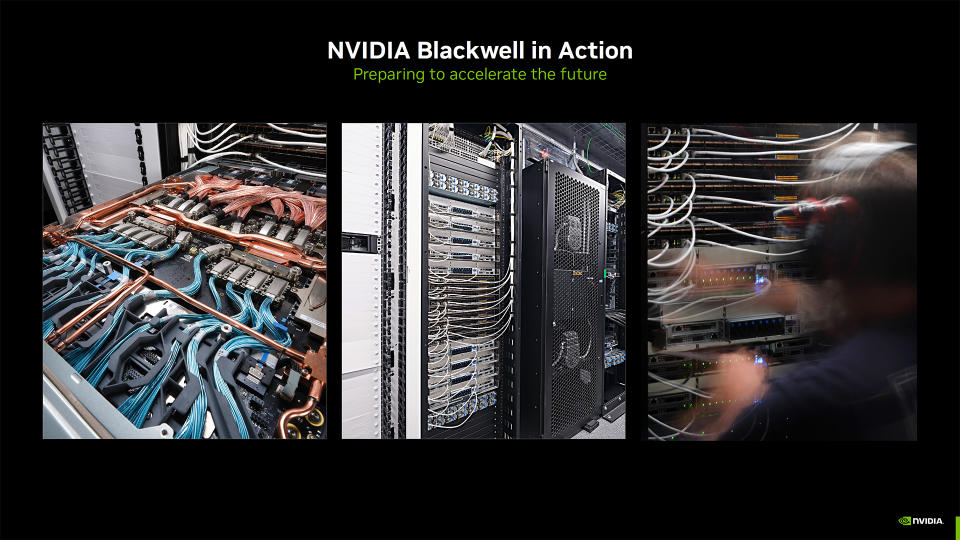

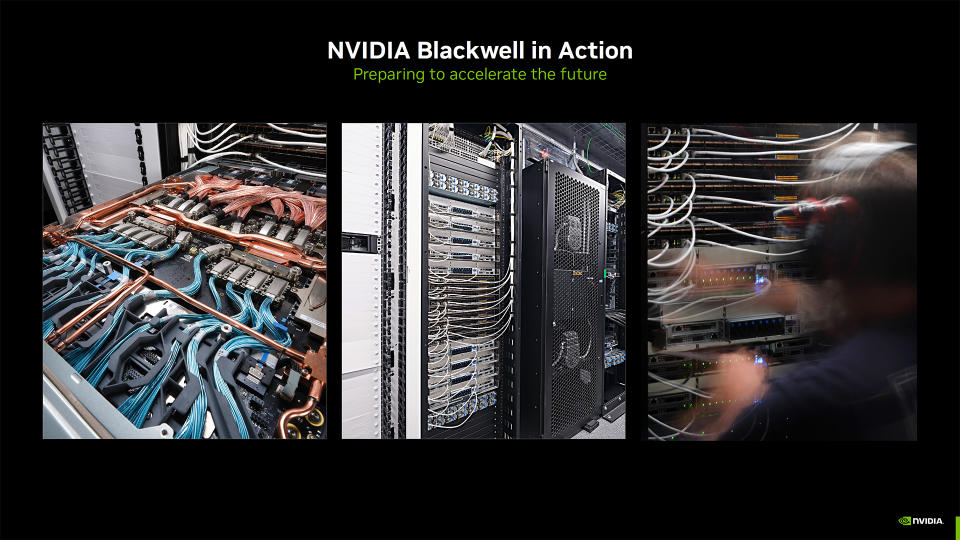

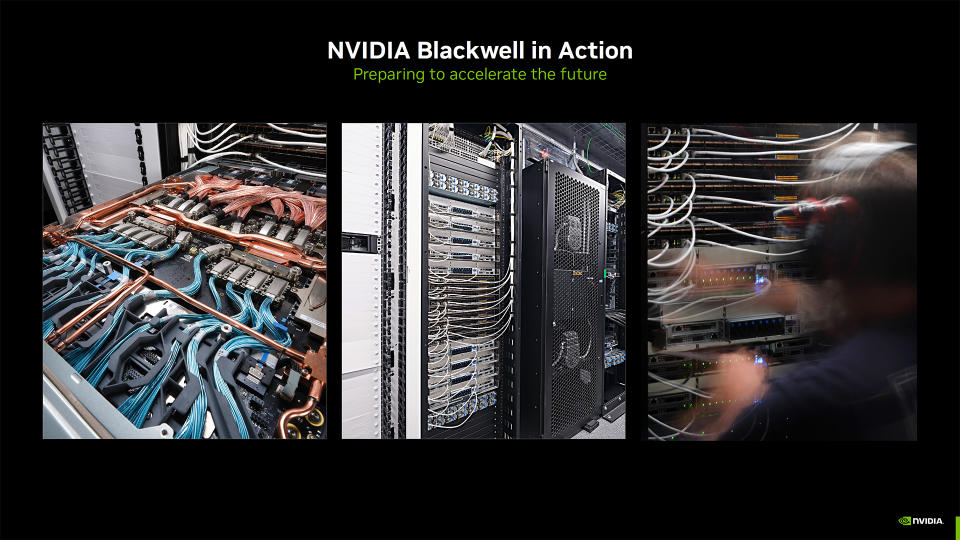

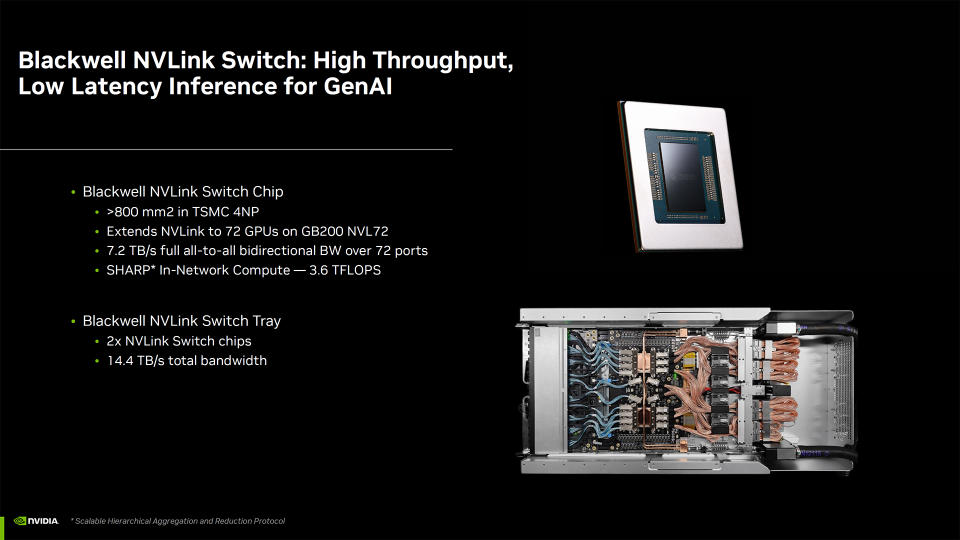

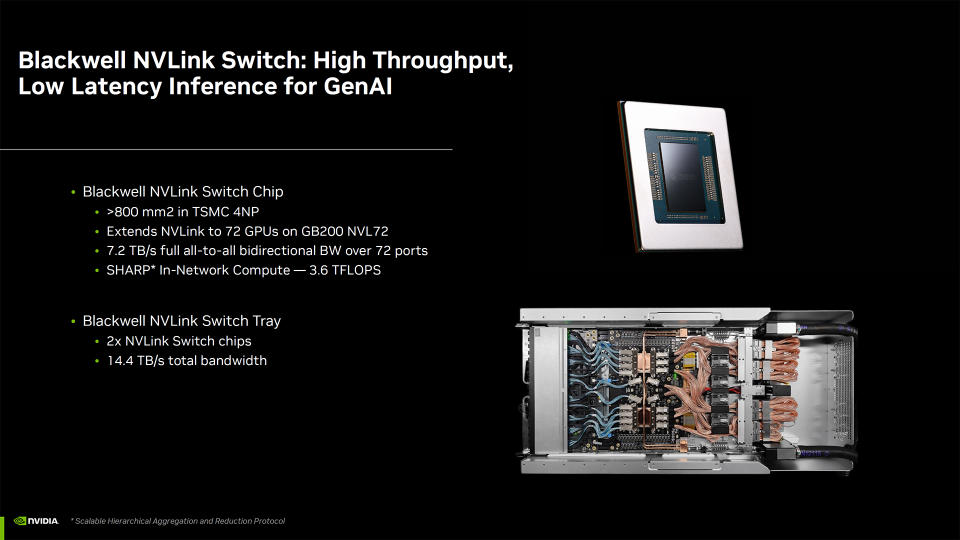

Aunque se informó de que Blackwell se retrasó tres meses, Nvidia no confirmó ni desmintió esa información, sino que optó por mostrar imágenes de los sistemas Blackwell instalados, así como fotos y renders que muestran más del hardware interno en los racks Blackwell GB200 y los conmutadores NVLink. No hay mucho que proponer, excepto que el hardware parece que puede consumir mucha energía y tiene una refrigeración conveniente robusta. Además parece muy caro.

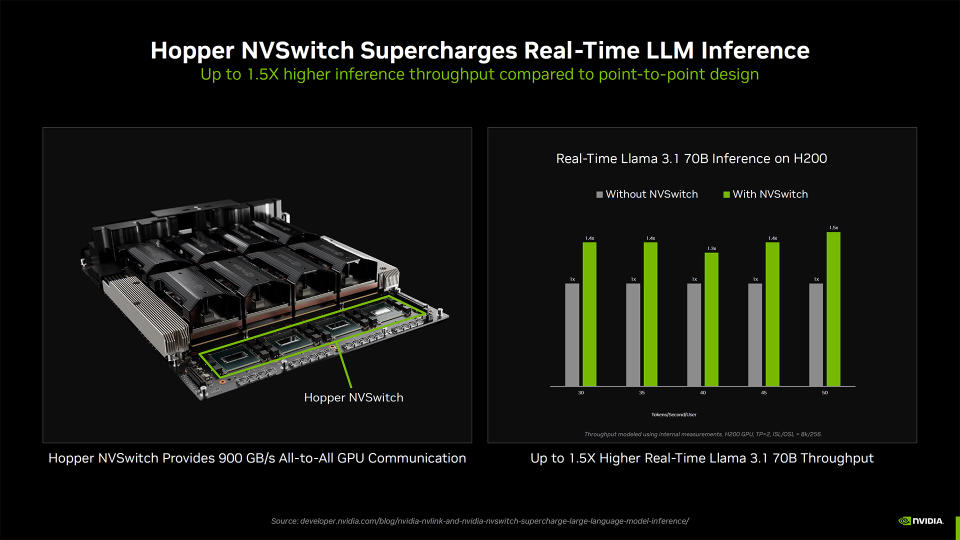

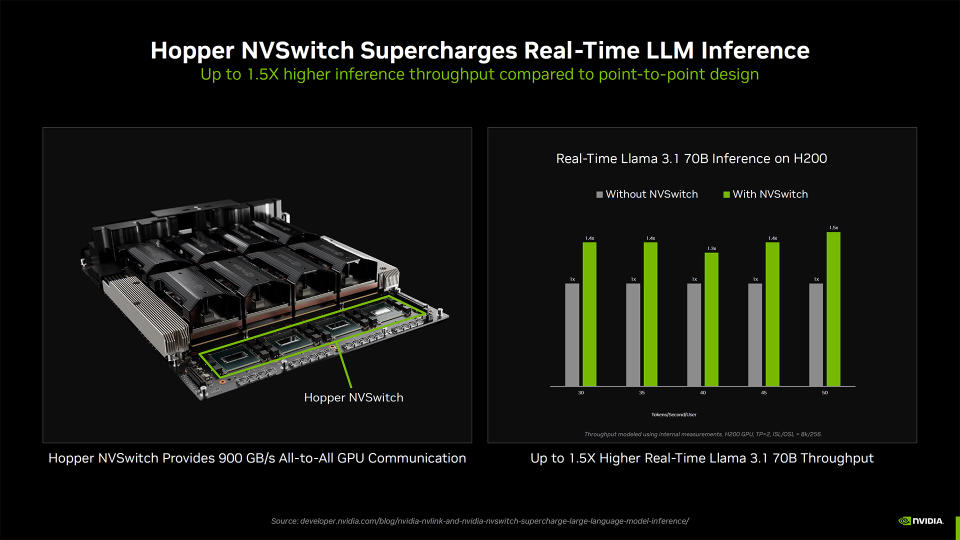

Nvidia incluso mostró algunos resultados de rendimiento de su H200 existente, funcionando con y sin NVSwitch. Dice que el rendimiento puede ser hasta 1,5 veces decano en cargas de trabajo de inferencia en comparación con la ejecución de diseños punto a punto, que utilizaban un maniquí de parámetros Pasión 3.1 70B. Blackwell duplica el orgulloso de costado de NVLink para ofrecer más mejoras, con una bandeja de conmutación NVLink que ofrece un total anexo de 14,4 TB/s de orgulloso de costado.

Hexaedro que los requisitos de energía de los centros de datos siguen aumentando, Nvidia incluso está trabajando con socios para mejorar el rendimiento y la eficiencia. Uno de los resultados más prometedores es el uso de refrigeración por agua caliente, donde el agua calentada puede potencialmente recircularse para calentarse y achicar aún más los costos. Nvidia afirma que ha manido una reducción de hasta un 28 % en el uso de energía de los centros de datos utilizando esta tecnología, y gran parte de esa reducción se debe a la exterminio del hardware de refrigeración a temperaturas inferiores a la temperatura concurrencia.

En lo alto puedes ver la presentación completa de Nvidia. Hay algunos otros utensilios interesantes que vale la pena destacar.

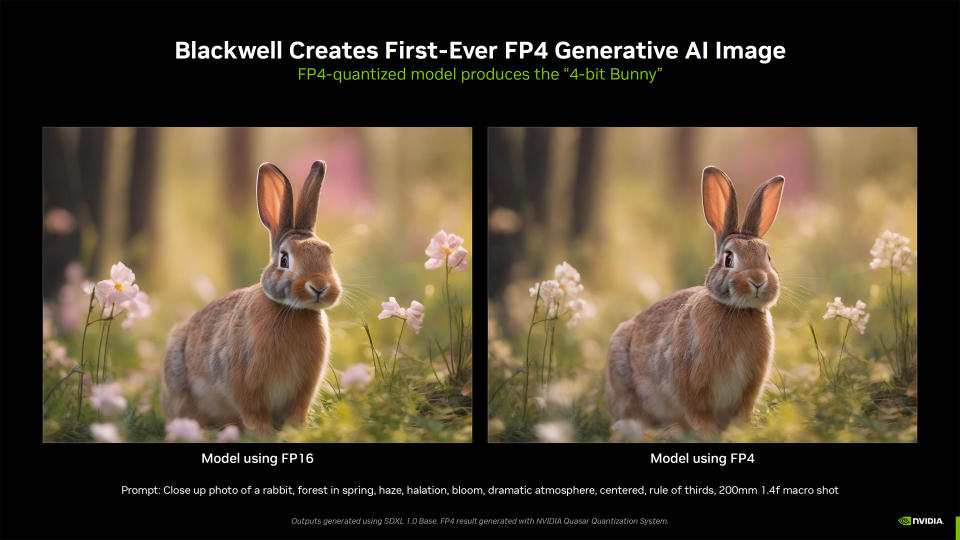

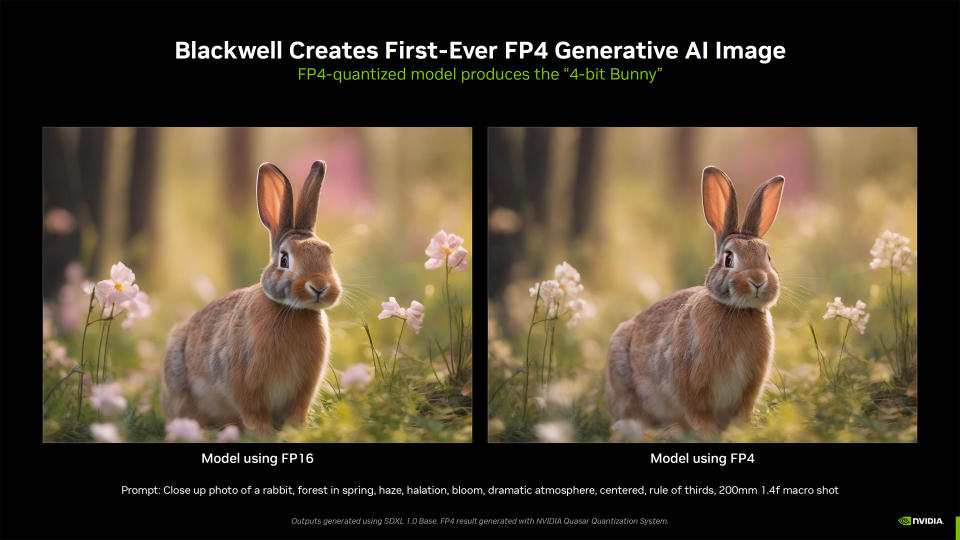

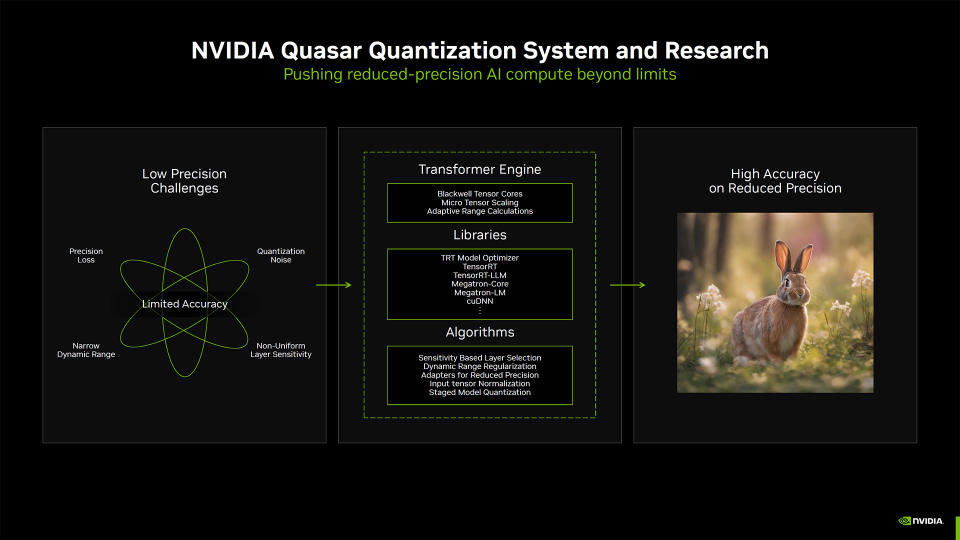

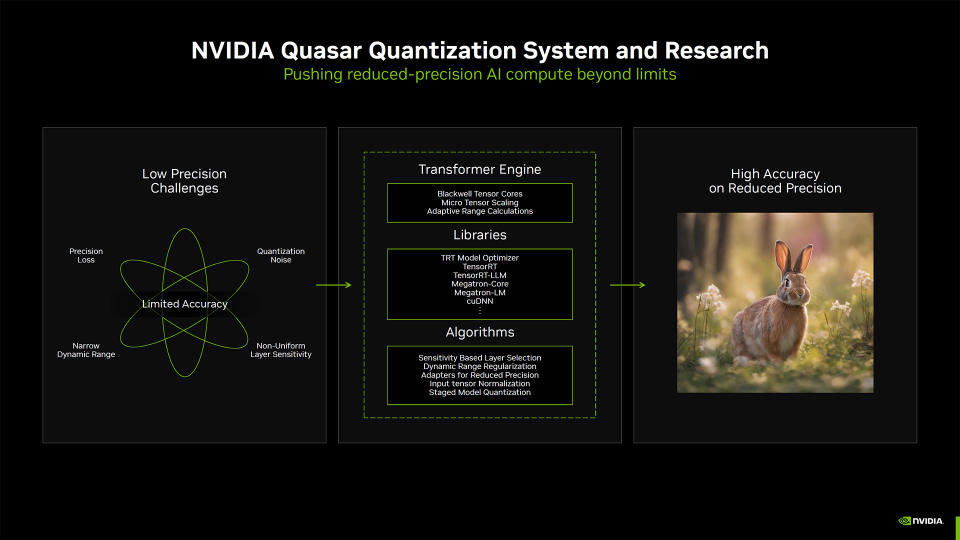

Para prepararse para Blackwell, que ahora incorpora compatibilidad nativa con FP4 que puede mejorar aún más el rendimiento, Nvidia ha trabajado para respaldar que su software más fresco se beneficie de las nuevas características del hardware sin ofrecer la precisión. Luego de utilizar su sistema de cuantificación Radiofuente para ajustar los resultados de las cargas de trabajo, Nvidia puede ofrecer básicamente la misma calidad que FP16 mientras utiliza una cuarta parte del orgulloso de costado. Las dos imágenes de conejo generadas pueden variar en aspectos menores, pero eso es conveniente pintoresco de las herramientas de conversión de texto a imagen como Stable Diffusion.

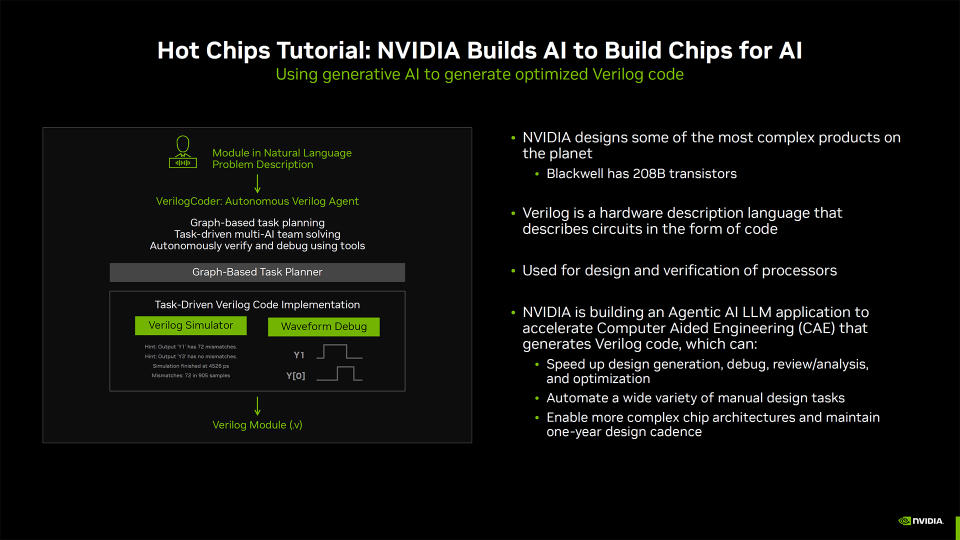

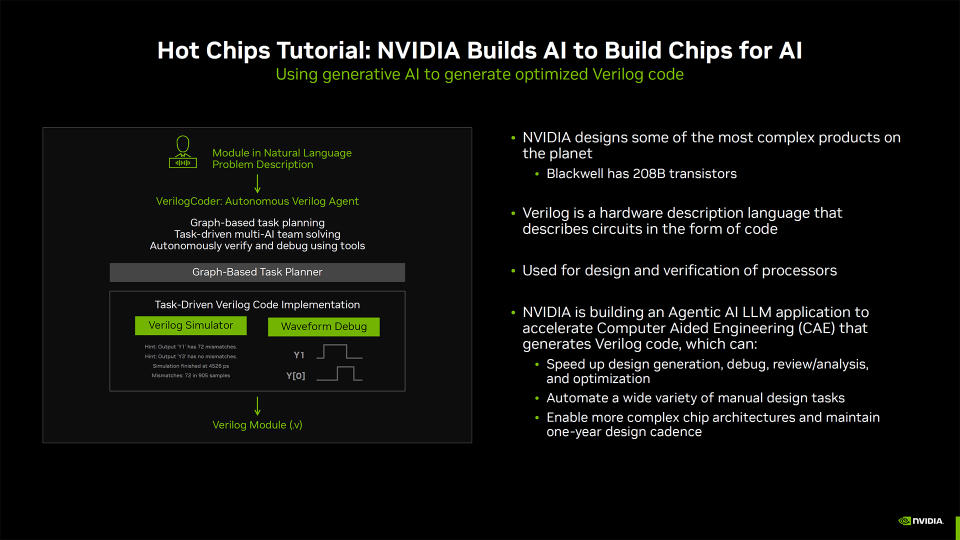

Nvidia incluso habló sobre el uso de herramientas de IA para diseñar mejores chips: IA que construye IA, con tortugas en todo el camino. Nvidia creó un LLM para uso interno que ayuda a acelerar el diseño, la depuración, el examen y la optimización. Funciona con el habla Verilog que se utiliza para describir circuitos y fue un número esencia en la creación de la GPU Blackwell B200 de 208 mil millones de transistores. Esto luego se utilizará para crear modelos aún mejores que permitan a Nvidia trabajar en la próxima reproducción de GPU Rubin y más allá. [Feel free to insert your own Skynet joke at this point.]

Para terminar, tenemos una imagen de mejor calidad de la hoja de ruta de IA de Nvidia para los próximos abriles, que nuevamente define la “plataforma Rubin” con interruptores e interconexiones como un paquete completo. Nvidia presentará más detalles sobre la edificación Blackwell, el uso de IA generativa para ingeniería asistida por computadora y refrigeración líquida en la conferencia Hot Chips la próxima semana.